Рейтинги, изначально задуманные как способ оценки деятельности университетов или различных ее аспектов, в последние годы все более явно трансформируются в инструмент влияния на управление университетами, в том числе через механизмы государственного финансирования, а в исключительных случаях даже влияют на национальную политику в области высшего образования. Таким образом создатели рейтингов, определяющие индикаторы успешности университета, становятся все более значимыми игроками академического мира, влияющими на формирование международного понимания качества образования, уровня научной деятельности и уровня университета в целом.

В основе успеха как идеи рейтингования в целом, так и отдельных рейтингов лежит доверие к методологии и агенту, обеспечивающему процесс. Принятые международным сообществом принципы качества и надлежащей практики при ранжировании вузов закреплены в Берлинских принципах ранжирования высших учебных заведений [1], принятых в 2006 году на конференции Международной экспертной группы по ранжированию (IREG).

Проблемами обеспечения такого доверия обусловлены дискуссии о том, должны ли принципы ранжирования университетов задаваться членами академического сообщества или независимыми экспертами, как в обоих случаях должны финансироваться разработка и функционирование рейтинга и возможно ли обеспечить объективную оценку университетов с учетом исторических, экономических, лингвистических и культурных аспектов систем образования разных стран. Для понимания важности учета этих различий достаточно сказать, что 40 % публикаций в международных реферируемых журналах подготовлены учеными, работающими в 200 лидирующих в рейтингах университетах. К теме доверия относятся также вопросы, связанные с возможностью независимой проверки результатов рейтинга.

В данной статье проанализированы особенности четырех наиболее популярных международных рейтингов университетов: QS, THE, ARWU, U-Multirank. Помимо популярности выбор обусловлен тем, что из представленных рейтингов два разработаны коммерческими компаниями и два – представителями академического сообщества. Два используют инструмент репутационного опроса для определения академических достижений университета, а два – нет. Три из выбранных рейтингов представляют результаты в формате так называемой таблицы лиг. Для финансирования всех четырех рейтингов используются существенно различающиеся схемы. Такой подход, на наш взгляд, несмотря на небольшую выборку, позволяет довольно полно описать многообразие существующих на сегодняшний день инструментов и механизмов рейтингования.

Сравнение методологий THE и QS [2]

В 2004 году был впервые опубликован рейтинг ведущих университетов мира, разработанный британской консалтинговой компанией QS совместно с британским еженедельным изданием Times Higher Education. Сотрудничество компаний продолжалось до осени 2009 года, когда в силу методологических разногласий компании расторгли договор и THE объявил о намерении создать новый рейтинг университетов мира. THE заключили соглашение о разработке методологии и проведении процедуры ежегодного рейтингования с компанией Thomson Reuter, а QS продолжили выпуск рейтинга, сохраняя прежнюю методологию и партнерство с Elsevier.

В прессе часто проводят параллели между этими рейтингами и сравнивают списки университетов, находящихся на лидирующих позициях. Из этих публикаций может сложиться впечатление, что рейтинги QS и THE используют очень похожие методологические подходы. Однако если присмотреться к деталям, становится понятно, что это не так. Мы предполагаем детально рассмотреть различия между этими рейтингами и сделать выводы о том, насколько стоит сравнивать их результаты.

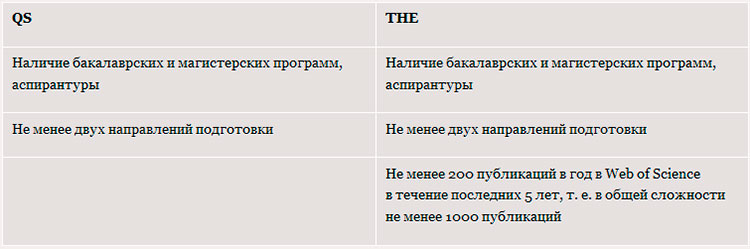

Входные критерии

Первое, на что необходимо обратить внимание, – это входные критерии, то есть те требования, которым должен соответствовать вуз, для того чтобы принять участие в рейтинговании.

Мы видим, что уже на уровне входных критериев THE для этого рейтинга подходят только те университеты, которые ведут активную исследовательскую деятельность. При этом в методологии отдельно есть указание на то, что, если университет ведет активную исследовательскую деятельность, но по определенным причинам не имеет указанного количества публикаций (например, в связи с небольшим количеством сотрудников, или предметная область, в которой работает университет, не предполагает большого количества публикаций, или соответствующие журналы не репрезентативно представлены в Web of Science), он может быть приглашен к участию в рейтинге на основе экспертного заключения специалистов компании Thomson Reuters.

Мы видим, что уже на уровне входных критериев THE для этого рейтинга подходят только те университеты, которые ведут активную исследовательскую деятельность. При этом в методологии отдельно есть указание на то, что, если университет ведет активную исследовательскую деятельность, но по определенным причинам не имеет указанного количества публикаций (например, в связи с небольшим количеством сотрудников, или предметная область, в которой работает университет, не предполагает большого количества публикаций, или соответствующие журналы не репрезентативно представлены в Web of Science), он может быть приглашен к участию в рейтинге на основе экспертного заключения специалистов компании Thomson Reuters.

Методология QS также предполагает оценку публикационной активности университета, однако активная публикационная деятельность не является обязательным критерием для участия в рейтинговании.

Одним из результатов этого различия является то, что в рейтинге QS 2012 года были представлены 14 российских университетов, а в рейтинге THE – 2 (всего за всю историю в рейтинг попадали 3 российских университета). Другим результатом является то, что в общей сложности в рейтинге QS в 2012 году приняло участие около 3000 вузов, а в THE – всего около 800.

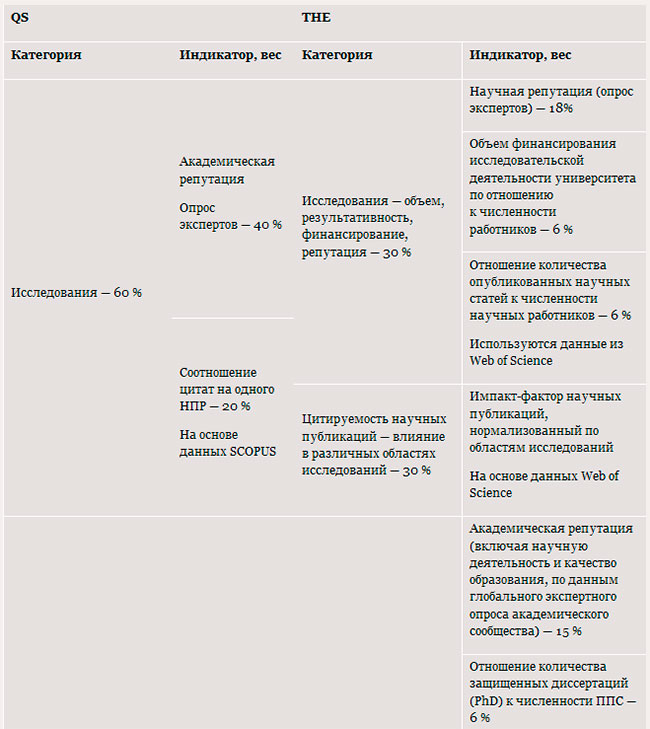

Оценка исследовательской деятельности

Рассмотрим принципы формирования состава экспертов, принимающих участие в репутационных опросах. В случае рейтинга QS база формируется на основе существующей многолетней базы академических контактов плюс ежегодно пополняемые предложения вузов – участников рейтингования. Речь идет о людях, которые либо занимают руководящие академические позиции в университетах: ректор, проректор, декан, зам. декана, зав. кафедрой, руководитель исследовательского центра (института, группы, лаборатории), либо имеют публикации в журналах, индексированных в Scopus. Предложенные списки анализируются, а затем принимается решение о включении того или иного эксперта в базу данных.

Всем экспертам, включенным в базу, ежегодно рассылается приглашение принять участие в опросе, на основании которого складывается показатель «Академическая репутация», составляющий 40 % веса рейтинга. Так, например, в опросе в 2012 году участвовали около 45 тыс. человек. По данным странового отчета QS, по России [3] в 2012 году на приглашение принять участие в опросе откликнулись 510 экспертов, из них 211 человек – уровня руководства университетов и подразделений. Таким образом, количество российских экспертов, участвовавших в опросе, составило 1,2 %, а Россия заняла 25-е место по степени активности экспертов. Важно отметить, что финальный показатель рассчитывается исходя из откликов последних трех лет.

Создатели рейтинга THE используют результаты опроса экспертов для оценки как научной, так и образовательной деятельности. Опрос экспертов составляет в общем весе рейтинга 33 %. По результатам опроса THE выпускают репутационный рейтинг, который публикуется отдельно от основного рейтинга.

База экспертов THE составляется автоматическим образом на основе списка авторов, опубликовавших работы в изданиях, входящих в Web of Science, в соответствии с нормализацией по данным ООН о представленности отдельных дисциплин в разных странах. Для более четкого понимания состава участников приведем данные о соотношении представителей различных дисциплин и стран.

К участию в опросе 2013 года, результаты которого будут опубликованы весной 2014 года, были приглашены представители научных направлений в следующем соотношении [4]:

22,1 % – социальные науки;

21,3 % – инженерные науки;

18,0 % – физические науки;

15,4 % – клинические науки, медицина;

12,7 % – науки о жизни;

10,5 % – гуманитарные науки.

По регионам приглашенные эксперты распределились следующим образом:

33 % – Северная Америка;

17 % – Западная Европа;

12 % – Восточная Азия;

10 % – Океания;

6 % – Восточная Европа;

по 5 % Южная Америка и Ближневосточные страны.

Ежегодно к опросу приглашаются 150 тыс. случайно выбранных авторов статей, опубликованных в Web of Science, в соответствии с приведенной нормализацией. В 2013 году общее число ответивших составило около 17 тыс. человек, которые представляли 144 страны.

В опросе отдельно учитываются мнения о научной и образовательной деятельности. Важно, что при подсчете результатов опроса отклики о научной и образовательной деятельности учитываются в соотношении 2 : 1. Это связано с тем, что, по мнению научного совета рейтинга, оценка научной репутации университета в большей степени отражает академические достижения, чем репутация в образовательной деятельности.

Несмотря на всю тщательность процедуры проведения опроса и подбора экспертов, результаты репутационного опроса ежегодно вызывают споры в академическом сообществе. Так, остаются необъяснимыми изменения позиций МГУ, который в 2011 году находился на 33-м месте в мире, в 2012-м вообще не попал в сотню, а в 2013-м оказался на 50-м месте.

Таким образом, мы видим, что, хотя оба рейтинга используют внешне похожий инструмент, существуют различия в подходе к формированию экспертной базы и архитектуры исследования мнения экспертов. Мы по сути имеем дело с существенно различающимися исследованиями. При этом следует отдельно отметить, что мы ведем речь не о релевантности того или иного подхода, а именно об их различии.

Интересно также, что для оценки исследовательской деятельности THE используют помимо опроса еще два индикатора:

– объем финансирования исследовательской деятельности университета по отношению к численности работников – 6 %;

– отношение количества опубликованных научных статей к численности научных работников – 6 %.

Оба показателя нормализуются по показателям экономики страны и предметным областям.

Оценка публикационной активности университета

Показатель «Цитируемость научных публикаций» в обоих рейтингах рассматривается как оценка авторитетности университета в различных научных сферах и его роли в распространении новых знаний и идей. В обоих рейтингах полученные данные нормализуются по различным научным областям.

Тем не менее необходимо обратить внимание на несколько моментов:

– этот показатель является индикатором в категории «Качество исследований» в QS, и является отдельной категорией в THE;

– различие веса: QS – 20 %, THE – 30 %;

– данные собираются на основе разных баз: QS – Scopus, THE – Web of Science;

– содержание показателя: QS – количество цитат на одного академического сотрудника, THE – импакт-фактор публикаций, то есть количество цитат на одну опубликованную статью. В случае рейтинга THE это основной индикатор, имеющий наибольший вес.

Для понимания масштаба анализируемых документов приведем статистику с сайта рейтинга THE: в 2012 году было проанализировано 50 млн цитат из 6 млн статей, опубликованных в 12 тыс. журналов, входящих в Web of Science в течение 5 лет. При этом важно отметить, что в 2012 году в расчет принимались статьи, опубликованные в 2006–2010 годах и процитированные в 2006–2011 годах.

Для понимания различия получаемых данных важно отметить также отличие содержания баз Scopus и Web of Science. Так, в Scopus около 20 000 научных журналов имеют статус Active, в Web of Science – около 12 000. Доля «уникальных» научных журналов в Web of Science составляет около 7 %, в Scopus – около 40 %, при этом доля социально-экономических и гуманитарных изданий в Web of Science существенно ниже соответствующей доли в Scopus. Количество русскоязычных журналов в Scopus значительно превосходит их количество в Web of Science.

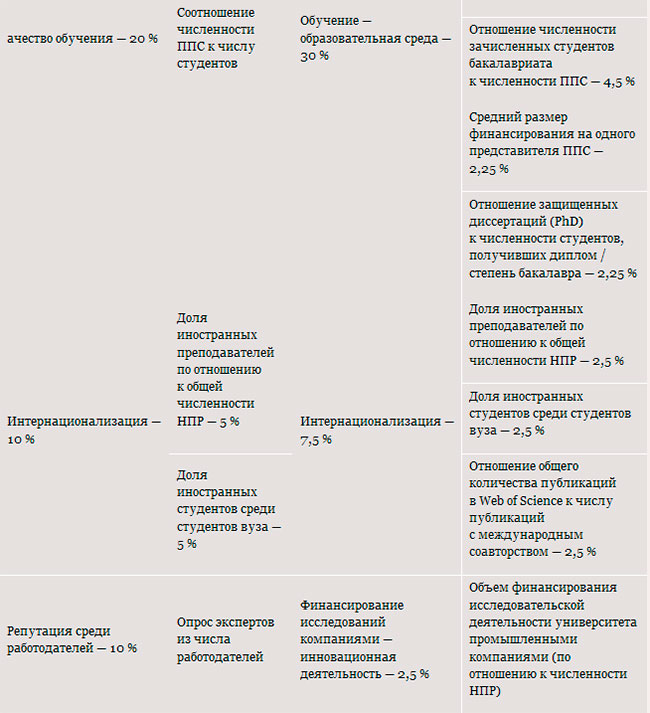

Категория «Обучение»

Рейтинг QS определяет качество обучения как соотношение количества студентов и преподавателей. Соответствующая категория содержит один индикатор, вес которого определен в 20 %. В методологии отдельно отмечено, что для подсчета этого индикатора в идеале было бы необходимо учитывать только сотрудников, занимающихся преподаванием, и исключить не ведущих преподавание исследователей. Однако из-за трудности валидирования этих данных на глобальном уровне на сегодняшний день в расчет принимается общее количество академических сотрудников.

Рейтинг THE определяет качество образования через качество образовательной среды и анализирует пять индикаторов, представляющих образовательную среду как со стороны преподавателей, так и со стороны студентов. Общий вес категории – 30 %.

Самый большой вес – 15 % – придается результатам репутационного опроса, который уже был описан выше. Далее следуют индикаторы:

– отношение количества зачисленных студентов бакалавриата к количеству преподавателей – 4,5 %;

– отношение количества защищенных диссертаций (кандидатских, докторских, PhD) к численности академического персонала (преподавателей и исследователей) университета – 6 %;

– отношение числа защищенных диссертаций (кандидатских, докторских, PhD) к численности студентов, получивших диплом / степень бакалавра – 2,25 %;

– средний размер дохода университета на одного академического сотрудника – 2,25 %.

Интернационализация

Это единственная категория, в которой индикаторы QS и THE сформулированы одинаковым образом: доля иностранных академических сотрудников и доля иностранных студентов среди студентов вуза. Единственное различие – вес индикаторов: QS – по 5 %, THE – по 2,5 %. Также THE учитывает отношение общего количества публикаций в Web of Science к числу публикаций с международным соавторством – 2,5 %.

Взаимодействие университета с бизнесом

THE и QS по-разному подходят к оценке взаимодействия университета с компаниями. QS рассматривает взаимодействие университета с компаниями через оценку репутации среди работодателей. Категория составляет 10 % от общего веса. Репутация определяется на основе опроса руководящих представителей компаний, список которых составляется также на основе собственных баз QS и предложений университетов – участников рейтинга.

THE подходит к этому вопросу с точки зрения финансирования компаниями исследований, ведущихся в университете. Авторы рейтинга рассматривают способность университета привлекать средства за счет трансфера знаний, содействия в реализации инновационных проектов, оказания консалтинговых услуг, а также готовность компаний оплачивать подобные услуги. Индикатор рассчитывается как соотношение объема полученных средств с количеством академических сотрудников университета и оценивается в 2,5 % от общего веса.

Финансовые показатели деятельности университета

При составлении рейтинга QS учитывается единственный финансовый показатель – это средняя стоимость обучения на магистерских и бакалаврских программах для местных и иностранных студентов (этой информации не видно в приведенной сравнительной таблице, так как она не является отдельным индикатором).

Рейтинг THE, как видно из таблицы, учитывает два финансовых показателя, связанных с финансированием исследовательской деятельности, и один – связанный с объемом дохода университета на одного преподавателя.

Сам факт использования финансовых показателей свидетельствует о различном подходе к анализу деятельности университета. С точки зрения теории рейтингования в случае QS речь идет об анализе результатов исследовательской и образовательной деятельности, а в случае THE анализируется также эффективность университета в вопросах привлечения и расходования финансовых средств.

Стабильность/устойчивость методологии

Методология рейтинга QS остается стабильной многие годы, что позволяет проводить объективные сравнения результатов рейтингования.

Методология THE постоянно совершенствуется, при этом дорабатываются индикаторы как основного рейтинга, так и рейтинга молодых университетов (100 under 50 – 100 университетов в возрасте до 50 лет). В качестве примера приведем последние изменения рейтинга молодых университетов, который был во второй раз опубликован в июне 2013 года.

Методология рейтинга 100 under 50 полностью соответствует методологии основного рейтинга. Однако по рекомендации экспертного сообщества были произведены изменения, суть которых сводится к снижению веса репутационных индикаторов с 33 % от общего веса до 22 %. Таким образом вес индикатора репутация в исследовательской деятельности снизился с 18 до 12 %, а индикатора репутация в образовательной деятельности – с 15 до 10 %. Освободившиеся проценты были перераспределены в пользу других индикаторов соответствующих категорий.

Мотивацией к изменениям стало то, что, по мнению академического совета рейтинга, в случае анализа достижений молодых университетов репутационный опрос имеет меньшее значение по сравнению с оценкой университетов, имеющих долгую историю. Соответственно эти изменения не касаются основного рейтинга [5].

Предметные рейтинги и рейтинги по отраслям науки

Оба издания одновременно с рейтингом университетов представляют также рейтинги по различным отраслям науки: социальные, гуманитарные, инженерные, естественные, науки о жизни и медицина. В THE отдельно выделяются физические науки. QS также составляет предметный рейтинг в рамках каждой из отраслей.

Как и при составлении основных рейтингов, есть существенные различия и в методологических подходах к составлению этих рейтингов. Для предметных и отраслевых рейтингов QS использует результаты экспертных опросов и анализ публикационной активности (индекс цитирования и H-index). Для каждого специализированного рейтинга каждый из индикаторов имеет свой вес, релевантный области знаний или рассматриваемой специальности. В случае THE у университетов в рамках общего сбора информации для участия в рейтинге запрашиваются одинаковые статистические показатели как по университету в целом, так и по соответствующим научным отраслям. С одной стороны, такой подход определенно делает работу университетов по сбору данных для участия в рейтинге намного более трудоемкой, но с другой – дает возможность соотносить научные и репутационные достижения с масштабом ведущейся в определенном научном направлении работы.

Расчет положения университета

Оба рейтинга используют определенный математический инструментарий, обеспечивающий возможность приведения к общему знаменателю результатов отдельных индикаторов. В случае QS достижения университета, набравшего самое высокое значение по определенному индикатору, принимаются за 100 условных единиц, а достижения остальных университетов рассчитываются соответственно пропорционально.

Этот принцип важен для понимания того, что достижения каждого университета определяются относительно достижений других университетов. Поэтому вполне возможна ситуация, при которой университет показывает более низкие по сравнению с предыдущим годом результаты, но это свидетельствует не о том, что его положение действительно хуже, а о том, что за последний год другие университеты совершили большой рывок.

Создатели обоих рейтингов отмечают: начиная с определенного момента различия в позициях университетов становятся настолько малы, что нет смысла ранжировать их по одному – более рационально объединять их в группы. В случае QS университеты объединяются в группы по 50 и по 100 начиная с 400-й и 600-й позиций соответственно. В случае THE групповое ранжирование по 25 университетов применяется начиная с 200-й позиции и по 50 – начиная с 300-й.

Академический рейтинг ведущих университетов мира [6]

История Академического рейтинга ведущих университетов мира (Academic Ranking of World Universities, ARWU), или Шанхайского рейтинга, как его принято неформально называть по названию университета, в котором он был разработан, началась в 1998 году. Интересно, что собственно задачу по разработке рейтинга никто не ставил. В 1998 году Шанхайский университет стал одним из десяти университетов, которые были включены в государственную программу КНР по финансированию высшей школы и науки в рамках «Проекта 985» и перед которыми правительством КНР была поставлена задача стать университетами мирового уровня [7]. В этой связи руководство университета поручило группе исследователей провести сравнение ведущих исследовательских университетов мира с достижениями университетов Китая.

Решая эту задачу, исследователи выявили открытые источники, фиксирующие научные достижения университетов, и затем проанализировали, какие университеты в них зафиксированы. Таким образом в сферу внимания исследователей попали университеты, представители которых соответствовали одному из следующих параметров:

– обладатели Нобелевских премий и медалей Филдса;

– ученые, входящие в список «Высокоцитируемые исследователи» (Highly Cited Researches) [8]; Gara?o vartai, plastikiniai langai, balkon? stiklinimas ir plastikin?s durys konkurencinga kaina Vilniuje NEO langai

– авторы статей, опубликованных в журналах Nature и Sciences;

– авторы статей, проиндексированные в течение последнего года в Thomson Reuters Science Citation Index [9] и Social Sciences Citation Index [10].

Для того чтобы соотнести достижения университета с его размером, дополнительно был введен показатель соотношения с численностью персонала вуза.

В результате проделанной работы был получен ранжированный перечень университетов, учитывающий данные параметры, который и стал основой рейтинга, впервые опубликованного в 2003 году.

Таким образом, история появления рейтинга зафиксировала несколько принципиальных отличий этого рейтинга от других популярных сегодня международных рейтингов. Основное отличие состоит в том, что все данные для рейтинга находятся в открытом доступе и легко проверяемы, что, с одной стороны, повышает доверие к результатам, а с другой – избавляет университеты от необходимости ежегодного предоставления статистических данных. Входным критерием является наличие в университете сотрудников одной из упомянутых выше категорий.

Если проводить аналогию с категориями рейтингов QS и THE, в этом рейтинге рассматриваются следующие категории: качество образования, уровень академических сотрудников, результаты и эффективность исследовательской деятельности.

Университеты, попавшие в рейтинг, также ранжируются по пяти отраслям:

естественные науки и математика

инженерные науки и технологии, компьютерные науки

науки о жизни и сельское хозяйство

клиническая медицина и фармацевтика

социальные науки

и 5 предметным направлениям:

математика

физика

химия

компьютерные науки

экономика/бизнес

К недостаткам рейтинга относится то, что в силу выбранных параметров в рейтинг попадают в большей степени университеты, ориентированные на развитие естественных и технических научных областей, а гуманитарные, социальные и экономические науки представлены в существенно меньшей степени. Всего в ранжировании участвуют около 1200 университетов, из которых рейтингуются лучшие 500.

U-Multirank [11]

U-Multirank – многомерный международный глобальный рейтинг университетов, разработанный по заказу Европейской комиссии в 2009 году. Изначальная идея состояла в том, чтобы разработать методологию рейтингования, позволяющую учесть все многообразие университетов и оценивать их достижения, избегая общепризнанных недостатков других международных рейтингов.

В результате конкурсного отбора разработка рейтинга была поручена консорциуму, состоящему из европейских университетов и исследовательских центров девяти стран. Во главе консорциума – Центр исследования высшего образования в Гютерсло, Германия, и Центр исследования образовательной политики Университета Твенте, Нидерланды.

Разработка методологии и пилотная стадия проекта длились около трех лет. В начале 2013 года признанный успешным проект получил грант Европейской комиссии в размере 2 млн евро на реализацию и развитие проекта на два года с возможным продлением финансирования еще на такой же срок. Первый результат рейтинга будет опубликован в начале 2014 года, будут проранжированы около 500 университетов. Планируется, что в 2015 году число участников составит не менее 800.

Разработанная методология ранжирования принципиально отличается от методологий рейтингов, описанных выше. U-Multirank не ставит перед собой задачи последовательно проранжировать университеты, а создает инструмент, предназначенный для многомерного ранжирования университетов в соответствии с критериями конкретного пользователя. Суть методологии в следующем.

Университеты представляют достаточно большой объем данных о преподавании и обучении (четыре индикатора), исследовательской деятельности (девять индикаторов), трансфере знаний (восемь индикаторов), интернационализации (шесть индикаторов), участии в жизни региона (пять индикаторов). По данным, представленным для каждого из индикаторов, достижения университета характеризуются как высокие, средние или низкие. Созданный инструментарий позволяет пользователям самостоятельно выделить значимые для них индикаторы и в результате получить группы университетов, которые в большей или меньшей степени соответствуют их требованиям.

U-Multirank подвергается масштабной критике как со стороны университетского сообщества, так и со стороны рейтинговых агентств. Часть критиков говорит, что, поскольку созданная методология не соответствует традиционной турнирной таблице, то есть не позволяет создать последовательный список университетов, – его нельзя называть рейтингом, так как он скорее является своего рода поисковой машиной. Некоторые представители академического сообщества, и в их числе есть весьма уважаемые университеты и ассоциации, называют необоснованным появление еще одного рейтинга, участие в котором потребует от университетов больших усилий по сбору и предоставлению данных. Кроме того, они считают нецелесообразным в условиях экономического кризиса расходование таких крупных сумм из средств Европейского союза на подобные цели.

В то же время, по оценкам независимых экспертов по рейтингованию, предложенная методология позволяет учитывать лингвистические, культурные, экономические и исторические аспекты образовательных систем, а также разницу миссий университетов.

Критика рейтингования

Сама идея рейтингования, методологии и инструменты существующих на сегодняшний день рейтингов подвергаются жесткой критике со стороны академического сообщества. Основные критические вопросы, помимо тех, что уже были обозначены в начале статьи, связаны с несколькими аспектами.

Как видно из проведенного анализа, многие индикаторы рейтингов ориентированы либо на фиксирование достижений университета в прошлом (число нобелевских лауреатов, публикации и цитаты, репутация и т. д.), либо на актуальных статистических показателях (количество иностранных студентов или сотрудников, соотношение студенты/преподаватели, объем финансирования и т. д.). Вопрос состоит в том, насколько подобная методология позволяет оценить актуальный потенциал развития университета.

Другой вопрос состоит в подходе к определению веса различных индикаторов. На примере сравнения рейтингов THE и QS хорошо видно, как совершенно одинаковые или близкие индикаторы имеют существенно различающийся вес. Кроме того, представленные изменения в методологии THE свидетельствуют о том, что вопрос определения веса неоднозначно трактуется и в среде экспертов по рейтингованию.

И, наконец, последний по очередности, но не по значимости вопрос состоит в том, насколько понимание академического превосходства, зафиксированное создателями международных рейтингов, соответствует приоритетным задачам, обозначенным в инициативах академического превосходства, реализуемых во многих странах.

Очевидно, что задача сравнения вузов и отдельных программ – объективная необходимость. Нельзя утверждать, что в рамках существующих рейтинговых инструментов эта задача находит адекватное решение. Однако тот факт, что эта тема находится под пристальным вниманием многих национальных и международных организаций и институтов, свидетельствует о том, что в ближайшее время будет вестись интенсивный поиск новых подходов к сравнению университетов. На сегодняшний день тренд новых решений видится в области методологии, разработанной проектом U-Multirank. Очевидно также, что на поле рейтингования вузов могут появиться новые игроки, которые предложат совершенно иные подходы к оценке деятельности как вузов в целом, так и отдельных подразделений и образовательных программ.

Примечания:

[1] IREG – International Observatory on Academic Ranking and Excellence (http://www.ireg-observatory.org).

[2] Использованы материалы сайтов www.topuniversities.com, www.timeshighereducation.co.uk и официальных презентаций.

[3] QS World University Ranking, Russia Country Report 2012/2013 (www.topuniversities.com/library).

[4] Данные с сайта http://www.timeshighereducation.co.uk/world-university-rankings/2013/rep...

[5] Подробное описание обновленной методологии см.: http://www.timeshighereducation.co.uk/world-university-rankings/2013/one...

[6] Использованы материалы сайта www.arwu.org и официальных презентаций.

[7] Животовская И. Г. Реформа высшего образования в Китае: проблема подготовки кадров // Экономика образования. 2007. № 5. С. 60–69 (http://quality.petrsu.ru/files/file/f_file/220.pdf).

[8] Highly Cited Research – исследование компании Thomson Reuter, которое выделило авторов около 250 наиболее цитируемых исследований в 21 предметной области. В рамках каждой предметной области таких исследований не более 0,5 %. Для анализа были взяты статьи, опубликованные в период 1981–2008 гг. Начиная с 31 декабря 2011 г. компания Thomson Reuter не поддерживает данное исследование в описанном формате и интегрирует его результаты в инструмент Essential Sciences Indicators. Более подробно: www.highlycited.com

[9] Thomson Reuters Science Citation Index: http://ip-science.thomsonreuters.com/cgi-bin/jrnlst/jloptions.cgi?PC=K

[10] Thomson Reuters Social Sciences Citation Index: http://thomsonreuters.com/social-sciences-citation-index/

[11] Использованы материалы сайта www.u-multirank.eu и официальных презентаций.

«Отечественные записки». №4 (55). 2013 г.

Читайте также на нашем портале:

«Российские историки и зарубежные журналы: некоторые размышления специалиста по истории России» Андрей Усачев

«Новая шоковая терапия и «реформа РАН»: реалии российской науки» Сергей Рогов

«Российская историческая наука и индексы научного цитирования» Виталий Тихонов

«Образование и наука: проблемы реформирования (материалы круглого стола)»

«РАН и будущее науки в России (материалы круглого стола)»

«Реформа образования: как не выплеснуть с водой ребёнка?» Круглый стол Фонда исторической перспективы